今月、ようやく日本語対応したApple Intelligence。

自分はずっとiPhone 12 Proを愛用していて、正直「まだ買い替えなくてもいいかな」と思ってたんだけど、iPhone 15 Pro以降じゃないとAppleのAI機能が使えないって話を聞いて、ちょっと期待してたんだよね。

とはいえ、いきなり15万円近くするiPhoneに手を出すのはちょっとなぁ…ってことで、「それならMacでApple Intelligenceを体験してみようかな?」っていう軽いノリで、対応モデルのMacBookを買ったのが数ヶ月前。

ただ、今になって思うと──

AI目当てでMacを買うのはちょっと早すぎたかもしれない。

今回はなぜMacユーザーである私がタイトル通り「Macでは微妙だけど最新iPhoneだと便利なんかな…」と思った理由を書き留めていく。

新AIでできることと私の使い方

まず、Apple Intelligenceでできるようになったことをざっと挙げると、こんな感じ。

- テキストの生成・校正(メールや文章の補助)

- 画像・絵文字の生成(Image Playgroundというやつ)

- 高度なファイル・通知管理(スマートな管理ができる)

- Siriがようやく賢くなった(かも?)

- メモアプリの利便性向上(音声要約など)

- WEBページの要約による効率的な情報収集

パッと見た感じ、Apple Intelligenceめっちゃ便利そうじゃん!って思うんだよね。実際、自分も「これならブログ書くのとか、メールの返信とか、もっと楽になるかも」と期待してた。でも、ここにはいくつかの“制約”があって、この制約が思った以上に重い。「あれ?そんなに使えなくない?」ってなったのが正直な感想。

テキストの生成・校正

テキストの生成と校正機能についてなんだけどブログを書いたりメールの送信をしたりする私にとって結構大きいメリットなんじゃないかと思えていたんだけど結論から言うと、今のところそんなに便利でもなかった。

というのも、この分野ってすでにChatGPTみたいな優秀なツールがすでに存在してる。そして実は、Apple Intelligence自体もChatGPTの力を一部借りて動いてる。

まぁそれはいいとして(コパイロットなども同様だし)

さらに厄介なのが、使えるアプリが限られてる。とのこと

現時点では主にiWork(Pages, Numbers, Keynote)、メールアプリ、メモアプリで使用が想定されていて他のアプリでは使えないこともあるそう。

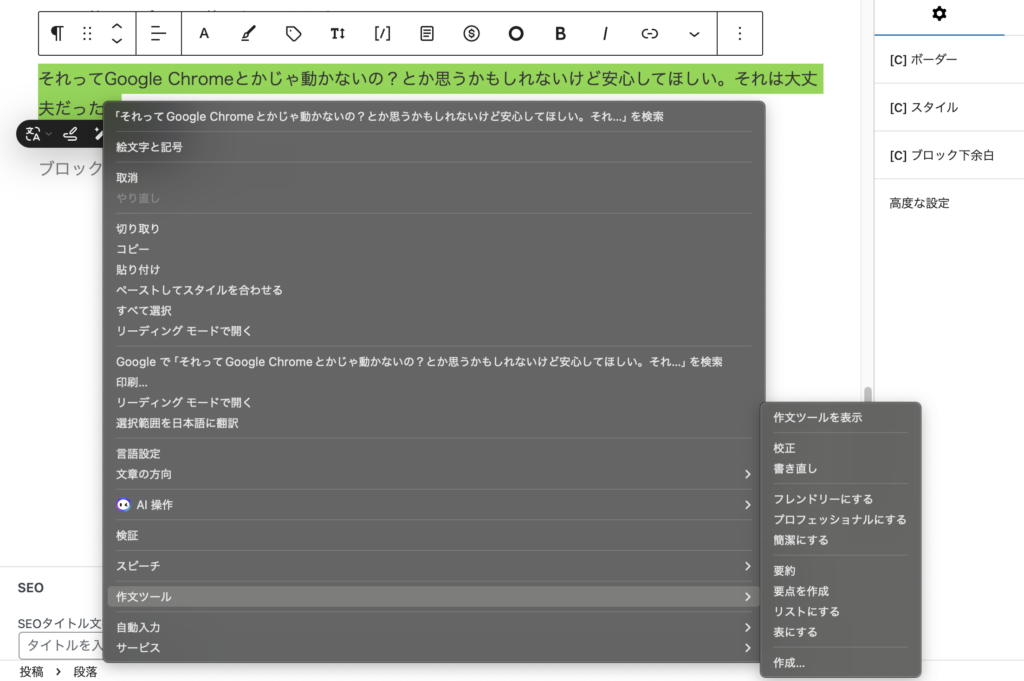

それってGoogle Chromeとかじゃ動かないの?とか思うかもしれないけど安心してほしい。それは大丈夫だった。

ただ使い勝手に疑問がある。たとえばWebページを右クリックして「要約」とか「校正」を選べば機能は動くんだけど、いちいち右クリックしてメニューを探して…っていう操作が必要になる。

(このブログの作成中にApple Intelligenceに指示を出すとなるとこんな感じ。「作文ツール」からAIにお願いできることを選ぶスタイル)

作業の流れを止めてしまうし、「もっとサクッとやってほしいんだよな…」って気持ちになる。

Macの使い方って、わりと“スムーズに作業したい派”の人が多いと思うから、AI機能が自然に溶け込んでないと逆にストレスなんだよね。

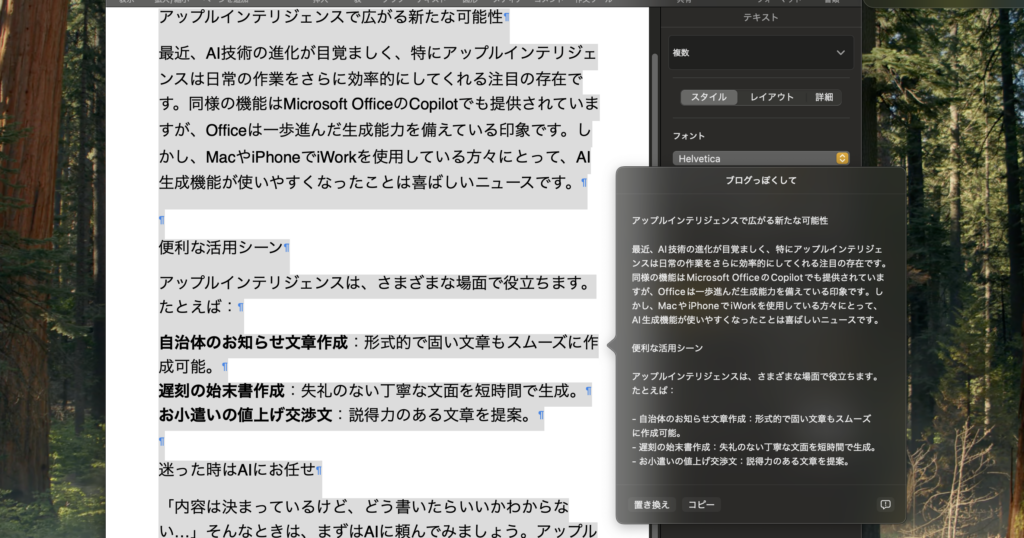

公式で使用が想定されているpagesではこんな感じ。今回はテストでApple Intelligenceの紹介文を「ブログっぽくして」とお願いしてみた。綺麗に整頓されてはいるが…

見ての通り「置き換え」か「コピー」しか出てこないので追加でお願いすることができない。

「使えること」と「使いやすいこと」って、やっぱり別物だなって実感した部分でもあった。

アドバイスをもらえない

上記でも説明したように、ChatGPTとかCopilotみたいに“会話しながら作業を進める”って使い方ができない。

「ここちょっと言い回し変えたいんだけど」とか、「これを要約して、あと文体はもうちょいカジュアルで」とか、そういうやり取りをしながら調整していく感覚がない。どちらかというと、Apple Intelligenceは“今ある文章を軽く整える”って感じの使い方がメインになってる。

だから、「アイディアを膨らませながらブログを書いていきたい」とか、「一緒に文章を作ってくれる相棒が欲しい」みたいな人にとっては、正直かなり物足りない。

使えるには使えるけど、“AIとの対話”を求めてる人にとっては、Apple Intelligenceはまだそこに届いておらず、正直まだかなり遅れている印象。

• ChatGPT(GPT-4)

• Copilot(MicrosoftのAI、GPTベース)

• Gemini(旧Bard、Google製)

会話できるAIといえばこのへんが代表格なんだけど、会話型での使いやすさや“対話の気持ちよさ”って観点で比べられない。

Siri、お前こんなもんなのか

私がApple Intelligenceに便利な使い方を求めるだけでなくChat GPTのような会話型を求めるのには大きな理由がある。それはSiriの存在だ。音声で指示を出したり、iPhone越しにちょっとしたやり取りができるっていう下地はもうあるわけで。

だからApple Intelligenceが登場するって聞いたとき、新しいSiriの幕開けとかいうもんだから「日常的にAIと自然に会話できるようになるのかも」ってかなり期待してた。

でも、フタを開けてみればそこまで劇的に進化したわけでもなかった。

Siriは相変わらず、ちょっと複雑なリクエストには弱くて、会話も続かないし、意図を汲んでの“提案”みたいなのはない。

会話型AIとして見たときに、ChatGPTみたいなやり取りをイメージしてると、たぶんガッカリすると思う。

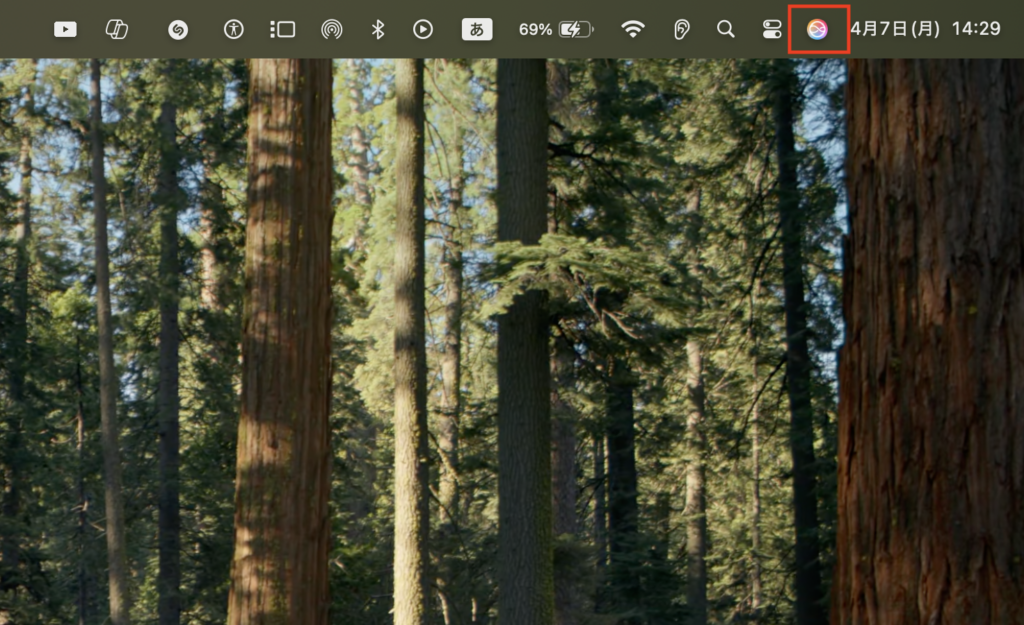

こんな感じでちょっとだけ新しくなったアイコンで画面の右上にSiri自体は駐在しているんだけどちょっと話しかけて「最近のAIについて教えて」と聞いてみるとこんな感じ。

そうか…

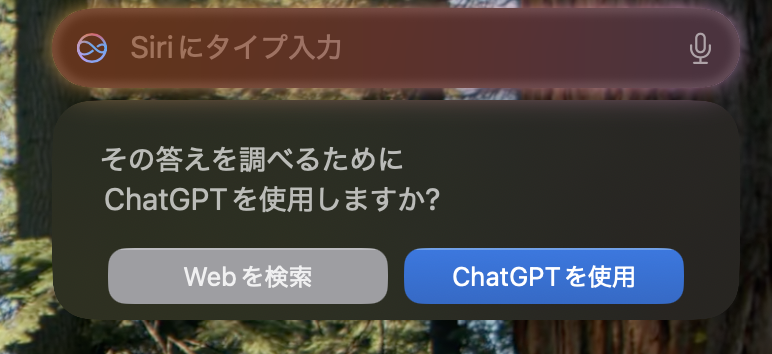

そしてChat GPTを使用すると答えると

こんな感じでしっかりした返答。上のタイプ入力からこの返答に対して掘り下げた質問もできる。

この質問の答えからいうとApple Intelligence自体は狭義のAIなのかなって…

画像生成も面白アプリ程度

あとちょっと触れておきたいのが、画像生成系の機能。上に貼った画像のアプリが「Image Playground」で画像生成のアプリケーション。他にも絵文字を作る「Genmoji」なんかがそれにあたるんだけど、これも正直…スマホのちょっと面白いアプリレベルの印象だった。

こんな感じで人のイメージを指定して下に表示されているテーマをくっつけた画像が生成される。今回は「ラブ」と「SF」を取り入れてみる。するとこんな感じで生成される。

今回はなんとなくの人物像を提案しているんだけどライブラリから人の写真を選んで作成することが可能でそっちの方がメインの使い方みたいな空気感あるんだけど、簡単なものであれば文章でお願いもできる。試しに「電子レンジとトースター」とお願いするとこんなかんじ。

ちなみに画像の候補は結構な数出してくれる。

こちらが提示する写真をイラストにしてくれるんだけど、それも程度難しくないものなら可能。

下から見上げた東京タワーを描いてもらったらこんな感じ。ぐにゃぐにゃのエッフェル塔ができた。

たしかに、自分の顔写真をベースに“ちょっとしたキャラ画像”を生成したり、ユニークな絵文字を作ったりっていうのは面白い。

でもそれって、「暇つぶし」や「SNSネタ」にはなるけど、クリエイティブな作業に本気で使えるほどの精度でも自由度でもない。

DALL·EやMidjourney、AdobeのFireflyあたりと比べると、まだまだ遊び感覚から抜け出せていないのが正直なところ。

Apple Intelligenceは今すぐ飛びつくほどではない

AIを期待して「Macもいいなぁ…」なんて考えている人がいるならば知っておいてほしいんだけどやっぱり全体的に、Apple Intelligenceは「これからに期待」な機能が多い。現時点では“あくまで補助的”がかなり大きい。

「AIを活用して文章書いたり、作業効率を上げたい」と思っているなら「あれ?ChatGPTでよくない?」ってなる場面の方が多いんじゃないかと思う。

繰り返しにはなるが、もしAI目当てでApple製品を、Macを買い替えようとしてる人がいるなら今はまだちょっと様子見でいいと思う。

いずれ機能が充実して、Siriが本当に賢くなって、他のアプリとも柔軟に連携できるようになったら…そのときが本番かもしれない。

最新iPhoneではカメラ面で活躍が期待できる。

Macのみでの利用だと結構微妙かなって感じなんだけどiPhoneでのApple Intelligence活用には“それなりにアリな部分”もある。

私は未だiPhoneを変える気は無いので(これはまた別の機会に説明する)検証は難しいんだけどYouTubeとかをみてるとiPhoneでの活用方法がたくさん動画で紹介されている。

おそらくSiriとかは説明した通りでiPhoneでもそんなに変わらないんじゃ無いかなと思うんだけどカメラではAIを用いた新しい機能が増えているらしい。特に写真アプリやカメラから直接AIを使って調べ物ができるのも地味に便利なポイント。

• 旅行中に見かけた建物や料理の写真を開いて「これなに?」って調べる

• スクショに写ってる電話番号や住所を長押しで自動認識&操作(電話かけたり、マップで開いたり)

• 手書きメモやホワイトボードを撮って、テキスト化・要約・整理みたいなことも可能

また今後は、カメラをかざしてリアルタイムで物の情報を得るみたいな使い方も強化されていく可能性あり。

こういう「目の前のものをそのままAIで処理できる」体験は、やっぱりスマホの機動力があってこそ活きる部分。

Macにはない“その場力”があるっぽい。そっちの方が魅力的。ただ結構言われてるんだけどライバルのGalaxyでは既にできる機能だったりするみたいなので(消しゴムマジック的なやつとか)参考にしてほしい。